Événements clés de l’histoire de l’informatique

📝 Mini-cours GRATUIT

De la mécanisation des calculs au logiciel

Du codage de l’information à l’objet numérique

La démocratisation de l’informatique

Les médias sociaux

📄 Annale PREMIUM

Sujet zéro — Numérique et sciences informatiques

🍀 Fiches de révision PREMIUM

Systèmes d'exploitation

Python / Variables

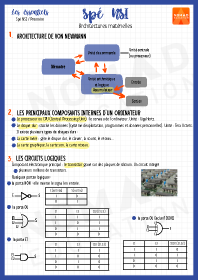

Architectures matérielles

Python : Fonctions – Librairies – Opérateurs booléens

Algorithmes de référence

Python : Structure de contrôle

Représentations des données : types construits

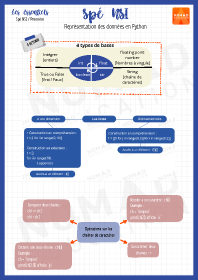

Représentation des données en Python

Spé NSI

📄 Annale PREMIUM

Sujet zéro — Numérique et sciences informatiques