La photographie numérique

📝 Mini-cours GRATUIT

Repères historiques

Les composants d'un appareil photo numérique

Les métadonnées d'une photographie numérique

Couleurs et formats

Quelques notions importantes liées à la photographie numérique

Les algorithmes de traitement d'image

🎲 Quiz GRATUIT

🍀 Fiches de révision PREMIUM

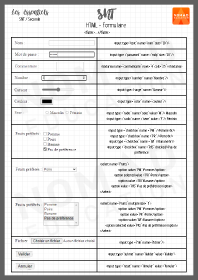

Html et CSS

Html formulaire

Le réseau

Les réseaux sociaux

Python

Architecture Client Serveur